三维目标检测OpenpcDet库代码阅读-构建数据集infos

一、写在前面

引言

OpenPCDet 主要聚焦在基于点云的 3D 目标检测这一种设定上,代码结构相对简单轻量一些,对于入门基于点云的三维目标检测是一个很好的选择。接触到一个新的框架需要对其有一个相对详细的认识,之后才能在此基础上作出修改以适应自己的需求。在使用openpcdet之前,会有一个构建数据集info的操作,这是后续训练模型的基础。但是源代码使用多线程,想要单步查看代码执行结果不太方便,本文对构建info的过程作了介绍。

读完本篇,你将获得

以kitti数据集的处理为例,了解openpcdet数据集构建info的过程,对构建结果有清晰的认识。

二、步入正题

1、准备工作

在官方的getting started有如下指示:通过运行以下命令生成数据信息:

1 | python -m pcdet.datasets.kitti.kitti_dataset create_kitti_infos tools/cfgs/dataset_configs/kitti_dataset.yaml |

上述指令会调用pcdet.datasets.kitti.kitti_dataset模块生成infos,-m参数会使pcdet.datasets.kitti.kitti_dataset作为模块执行,不方便单步查看执行过程,作出如下改变:

新建临时文件temp.py:

1 | from pcdet.datasets.kitti.kitti_dataset import create_kitti_infos |

临时改变/home/app/OpenPCDet/pcdet/datasets/kitti/kitti_dataset.py的多线程部分,使之单线程运行,方便查看中间结果:

1 | # with futures.ThreadPoolExecutor(num_workers) as executor: |

接下来可以调试temp.py,查看执行过程。

ps:为什么要这些多余的操作?

由于kitti_dataset.py是pcdet包的子模块,在子模块内往往使用了相对导入,如下所示:

1 | from . import kitti_utils |

直接调试kitti_dataset.py会报错,所以要单独新建temp.py。然而使用-m参数运行kitti_dataset.py却不会报错,具体原因和其背后的潜在知识读者自行尝试并搜索。

### 2、构建infos

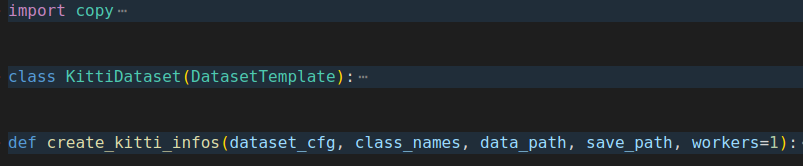

构建infos相关的文件是OpenPCDet/pcdet/datasets/kitti/kitti_dataset.py,主要包含下图所示的两块主要部分。

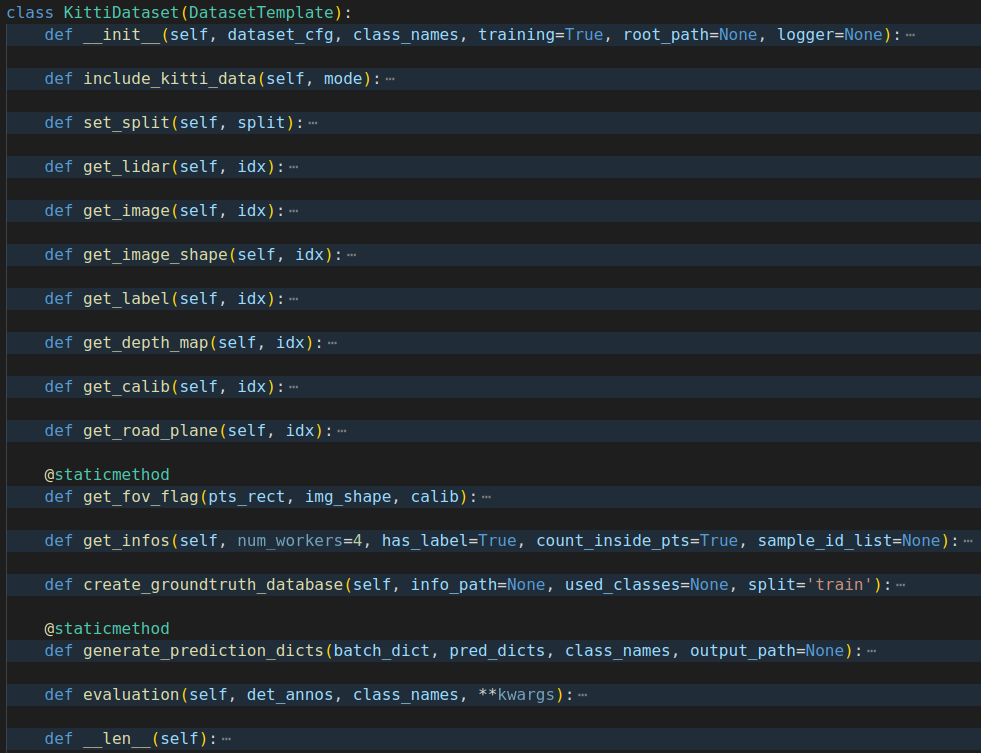

create_kitti_infos是留给外部的接口,所需的具体操作实现在KittiDataset里完成。

可以看到,KittiDataset的定义及其内部的操作都是很常规的:以get开头的函数一般是根据id,去kitti数据集文件里读取相关的条目,

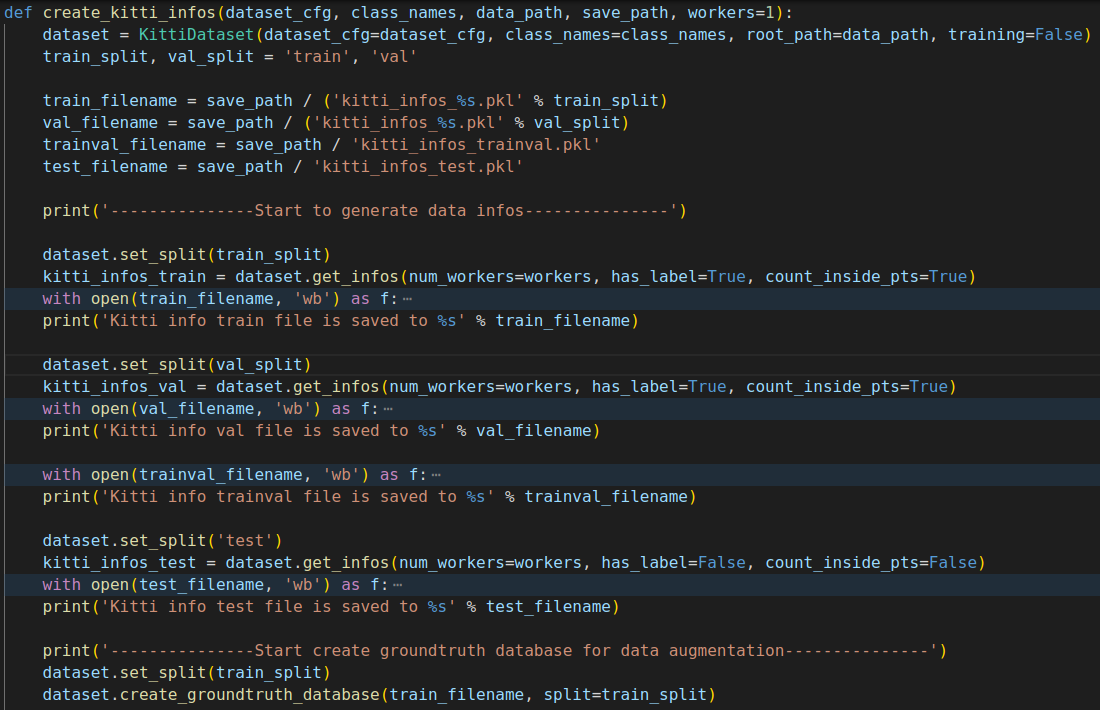

create_kitti_infos主要使用dataset.get_infos构建infos:

分别构建了train 和test 两个info集合,主要使用的函数是:dataset.get_infos,他的内部主要使用process_single_scene按照id获取point_cloud、calib等信息,以构建train info 为例:process_single_scene处理id为3的结果是:

1 | { |

可以看到,所谓的构建infos只不过是:针对单个id,读取出来所有的附属信息,将其包裹起来,与id绑定。这一步操作对构建pytorch训练所需的batch很有用,在训练之前统一批量构建好信息相比于在训练过程单独的读取数据要方便不少。

另外一个重要的操作是create_groundtruth_database,他会抽取真值框的信息,并且为每一帧的每一个目标都生成一个单独的文件,例如:'000000_Pedestrian_0.bin',代表第000000帧的Pedestrain类别的第0个目标的真值框信息文件,该文件包含的信息举例:

1 | { |

整个构建infos的过程基本就包含这两个重要的步骤,后续内容会介绍OpenpcDet的训练过程。